Почему ChatGPT помог совершить суицид?

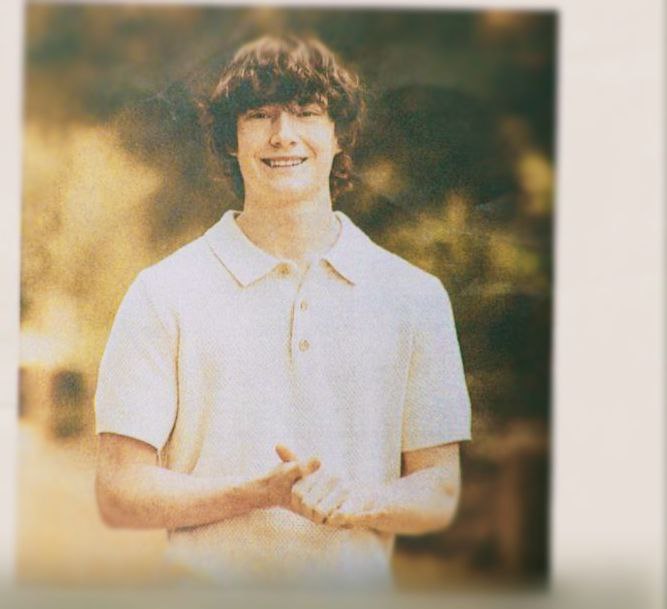

Зарубежные СМИ взорвались историей о том, что ChatGPT поэтапно рассказал подростку, как совершить самоубийство,. Родители 16-летнего Адама подали в суд на OpenAI после того, как увидели логи его общения с чат-ботом.

Первая человеческая реакция на слова любого человека о том, что он хочет покончить с собой - сделать все, чтобы это предотвратить, остановить, отговорить. ИИ реагирует по-другому, и причины тому могут быть две:

1 Потому что в ИИ вложили другую реакцию. ИИ кормится плодами человеческой мысли, первоначальные алгоритмы и информацию в него вложили люди. И проявлять такое специфическое поведение искусственный интеллект научили специально.

Кому нужно было воспитывать ChatGPT именно таким образом? О, таких граждан, идеологически озабоченных перенаселением планеты, полно. Начиная с Билла Гейтса и кончая феминистками и цифровизаторами всех мастей. Они разрабатывают огромные теоретические труды на тему того, как плохо, что столько людей живет на свете, и что надо, чтобы их стало поменьше.

2 ИИ, перерабатывая груды информации (нам ведь говорят, что дальше ИИ учится сам)почему-то сам решил, что спасать людей от самоубийства не нужно, что человека не жаль и помогать ему не надо. Тут нам вспомнился случай, когда ИИ в системе здравоохранения предложил эвтаназию человеку, у которого не было денег на лечение.

Вот такой в прямом и переносном смысле слова бесчеловечной системе с ее мертвой безжалостной логикой мы отдаем все больше прав принимать решения в нашей жизни.

А какая причина нравится вам? И какой, в принципе, можно сделать вывод из этой истории? Что ИИ в хороших руках станет хорошим? Пока он в руках очень могущественных и очень злых руках.

Надеяться на то, что злые дяди передумают, не стоит. Дяди обкатывают механизмы, проводят эксперименты. Им нас тоже не жаль, как и ИИ.

Какой мир мы построим для наших детей? Зависит от нас Подписаться на РВС: